AI-Driven Decision-Making in the Clinic (vALID)

Kurzbeschreibung

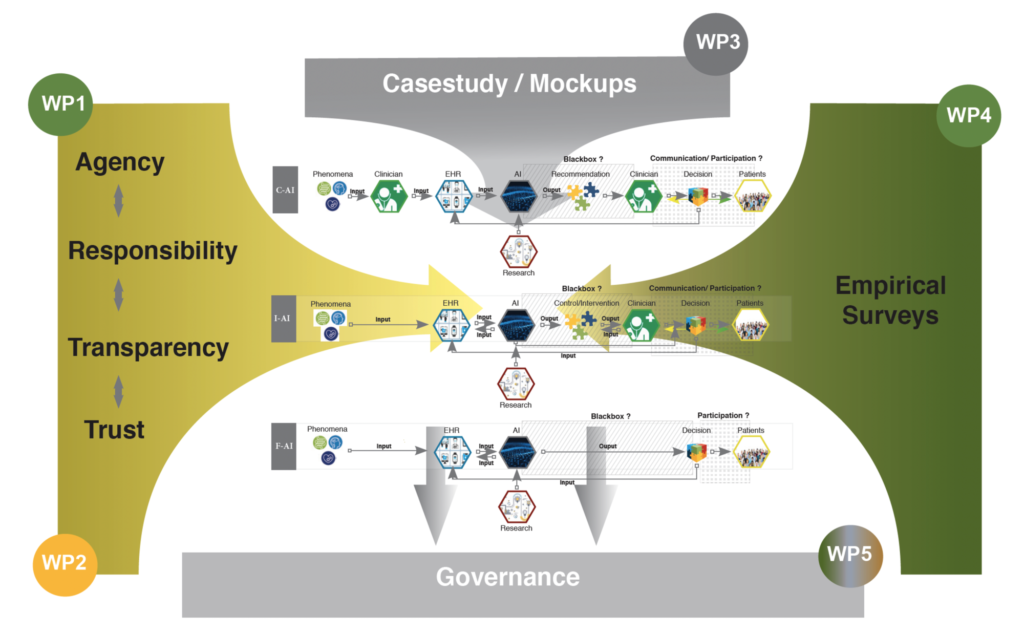

Künstliche Intelligenz (KI) scheint in aller Munde. Von zunehmender Bedeutung sind Anwendungen von KI im Bereich klinischer Entscheidungsfindung. Liegen einige der denkbaren Anwendungen klinischer KI noch in der Zukunft, verändern andere bereits die Praxis. Das Projekt vALID unternimmt eine normative, rechtliche und technische Analyse der Frage, wie KI-gesteuerte klinische Entscheidungsunterstützungssysteme mit dem Ideal der Arzt- und Patientensouveränität in Einklang gebracht werden können. Es untersucht, wie Konzepte von Vertrauenswürdigkeit, Transparenz, Akteurschaft und Verantwortung durch klinische KI beeinflusst und verschoben werden—sowohl auf theoretischer Ebene als auch im Hinblick auf konkrete moralische und rechtliche Konsequenzen. Eine der Hypothesen von vALID ist dabei: Die Grundbegriffe unseres normativen und bioethischen Instrumentariums sind von Bedeutungsverschiebungen betroffen. Und zwar: Je nach Einbettung der in Entscheidungsprozesse werden die Interaktionsmodi der beteiligten Akteure unterschiedlich verändert. vALID untersucht deswegen folgende Problemstellungen: Welche Akteure sind an der klinischen Entscheidungsfindung wie beteiligt, wenn KI als Drittes neben ÄrztIn und PatientIn hinzutritt? Wer ist für Fehler verantwortlich? Was würde es heißen, die Black Box KI in der Klinik für AnwenderInnen und Betroffene transparent zu machen? Wie könnte in diesen Kontexten dem Ideal der vertrauenswürdigen KI in der Klinik entsprochen werden?

Die Analyse basiert auf einer empirischen Fallstudie, welche anhand von Mock-up-Simulationen KI-getriebener, klinischer Entscheidungsunterstützungssysteme systematisch die Einstellung von Ärzten und Patienten zu einer Bandbreite von Designs und Implementierungen erfasst. Ziel ist schließlich die Erarbeitung von interdisziplinären Handlungsempfehlungen für Systemdesign, Regulierung und Implementierung KI-gestützer klinischer Systeme, die Prozesse nicht nur optimieren, sondern ÄrztInnen- und PatientInnensouveränität beim Einsatz dieser Technologie in den Mittelpunkt rücken

Mittelgeber: Bundesministerium für Bildung und Forschung (BMBF)

Akronym: vALID – AI-Driven Decision-Making in the Clinic

Projektzeitraum: 2020–2023

Teilprojekte

Ethisches Teilprojekt

Das Forschungsprofil des Lehrstuhls für Systematische Theologie II (Ethik) an der Friedrich-Alexander-Universität Erlangen-Nürnberg wird im Wesentlichen durch eine fundamentaltheologische und konkrete Ethik geprägt, und umfasst insbesondere Fragestellungen im Bereich der Bio- und Sozialethik. Ethik wird dabei als Wissenschaft verstanden, die normative Fragen detektiert und im Hinblick auf Voraussetzungen und Konsequenzen hin analysiert, Kriterien für die Beurteilung von Konfliktlagen ermittelt und damit zugleich auch Entscheidungsträger berät. In vALID werden dafür in einem ersten Schritt bisher in der Literatur beschriebene ethische Herausforderungen im Umgang mit künstlicher Intelligenz im Allgemeinen sowie in klinischen Kontexten im Besonderen analysiert. In einem zweiten Schritt reflektiert das Teilprojekt kritisch auf Lücken und Aporien in bisherigen Problembeschreibungen und Lösungskonzepten. Schließlich werden in einem dritten, konstruktiven Schritt und in enger Verzahnung mit den vALID-Teilprojekten Leitideen für die verantwortungsvolle Gestaltung klinischer, KI-basierter Entscheidungsunterstützung erarbeitet. Eine der Hypothesen ist dabei, dass beim Einsatz dieser Technologien neben der Optimierung von Prozessen und Entscheidungsfindung vor allem die Souveränität von ÄrztInnen und PatientInnen in den Mittelpunkt rückt.

Rechtliches Teilprojekt

Das vALID-Team der Universität Hannover (Lehrstuhl für Strafrecht, Strafprozessrecht, Strafrechtsvergleichung und Rechtsphilosophie von Prof. Dr. Susanne Beck) beschäftigt sich im Rahmen des Projekts mit rechtlichen Fragen der durch künstliche Intelligenz gestützten Entscheidungsfindung im klinischen Bereich.

Gerade bei medizinischen Entscheidungen spielen Transparenz und klare Verantwortungsverteilung eine zentrale Rolle. Nur so lassen sich Handlungsmacht der Ärzte und Selbstbestimmung der Patienten soweit wie möglich garantieren. Der Einfluss von KI auf die Entscheidungsfindung verändert unser bisheriges Verständnis dieser Konzepte. Zur genaueren rechtlichen Betrachtung dieser Problematik wird im vALID-Projekt in einem ersten Schritt der rechtliche Status Quo bezüglich des Einsatzes von KI im Rahmen von medizinischen Entscheidungen erarbeitet. Anschließend werden Lösungsansätze identifiziert und diese auch mit Blick auf andere Rechtskulturen betrachtet. In engem Austausch mit den Projektpartnern werden die empirischen Ergebnisse rechtlich bewertet und mit den ethischen Überlegungen verknüpft. Im Mittelpunkt steht daher die Ausarbeitung adäquater Praktiken für medizinische Entscheidungen mit Hilfe von KI-Systemen, welche auch weiterhin eine Zuschreibung rechtlicher Verantwortung unter gleichzeitiger Wahrung der Patientenautonomie erlauben. Eines der wichtigsten Ziele ist es, zusammen mit den Projektpartnern geeignete Richtlinien zur Schaffung neuer gesetzlicher Regelungen für den Einsatz von KI im medizinischen Kontext zu entwickeln.

Technisches Teilprojekt

Das Speech and Language Technology Lab des DFKI forscht seit längerem im medizinischen Bereich, beispielsweise in der Vorhersage von Ereignissen aufgrund der Auswertung von schriftlicher Dokumentation in Kombination mit strukturierten Daten oder an der Verbesserung der Arzt-Patient-Kommunikation. In mehreren Projekten, an denen auch die Charité beteiligt war und ist, sind Lösungen und prototypische Systeme entstanden, die nun im Projekt vALID speziell unter dem Gesichtspunkt der sich ergebenden ethischen, rechtlichen und sozialen Fragen in einer Mischung aus empirischen Untersuchungen und theoretischen Erörterungen untersucht werden. Hierbei werden zum Teil die bereits existierenden Modelle und Algorithmen eingesetzt und zum Teil wird auf Simulationen (Mock-Ups) zurückgegriffen werden, wo die heutige Technologie noch nicht so weit ist. Ein Ziel hierbei ist es, zusammen mit Medizinern und Patienten konkrete Anforderungen an zukünftige Sprachtechnologie zu entwickeln, wie beispielsweise die Erklärfähigkeit oder Transparenz gestaltet sein müssten, um die Entscheidungssouveränität der Mediziner und Datensouveränität der Patienten zu maximieren.

Empirisches Teilprojekt

Die AG Digitale Nephrologie der Charité entwickelt und pflegt seit 3 Jahrzehnten eine elektronische Patientenakte aller in Berlin nierentransplantierter Patient*innen. Auf Basis dieser hochwertigen Daten ist zur Verbesserung der Versorgung mittelfristig eine Integration von Clinical Decision Support Systemen (CDSS) auf Basis von Machine Learning Algorithmen in die bestehende Informations- und Dokumentationsoberfläche geplant. Während bereits erste Studien zur Performance vom KI-Systemen im Vergleich zu Ärzt*innen in der Vorhersage klinisch relevanter Endpunkte beginnen, sind systematische Untersuchungen bezüglich der Akzeptanz solcher Systeme auf Seiten von Ärzt*innen und Patient*innen, aber auch ethischer und rechtlicher Implikationen rar. Im Rahmen von vALID werden in Zusammenarbeit mit dem DFKI verschiedene Szenarien entwickelt, welche CDSS zunehmenden Autonomiegrades und mit unterschiedlich differenzierten Erklärungsmodellen des KI-Algorithmus simulieren. Im Rahmen einer Studie mit Ärzt*innen der Transplantationsambulanz der Charité werden anhand dieser Szenarien Daten über die Chancen und Risiken, sowie zu technisch-praktischen, ethischen und juristischen Fragestellungen, die sich in dieser besonderen Mensch-KI-Interaktion ergeben, gesammelt, welche als Grundlage für eine datenbasierte, interdisziplinäre Diskussion über KI in der Medizin dienen sollen.

Publikationen

- , , , , , , , , , :

Klinische Entscheidungsfindung mit Künstlicher Intelligenz - Ein interdisziplinärer Governance-Ansatz

Berlin, Heidelberg: Springer, 2023

(Essentials)

ISBN: 9783662670071

DOI: 10.1007/978-3-662-67008-8

- , , , :

A Primer on an Ethics of AI based decision support systems in the clinic

In: Journal of Medical Ethics (2020)

ISSN: 0306-6800

DOI: 10.1136/medethics-2019-105860

- , , :

Own Data? Ethical Reflections on Data Ownership

In: Philosophy & Technology (2020)

ISSN: 2210-5433

DOI: 10.1007/s13347-020-00404-9

URL: https://link.springer.com/article/10.1007/s13347-020-00404-9

- , :

Contact-tracing apps: contested answers to ethical questions

In: Nature 583 (2020), S. 360

ISSN: 0028-0836

DOI: 10.1038/d41586-020-02084-z

URL: https://www.nature.com/articles/d41586-020-02084-z

- , :

Just data? Solidarity and justice in data-driven medicine

In: Life Sciences, Society and Policy 16 (2020), Art.Nr.: 8

ISSN: 2195-7819

DOI: 10.1186/s40504-020-00101-7

URL: https://lsspjournal.biomedcentral.com/articles/10.1186/s40504-020-00101-7

- , , , , , , , , , , , :

Evaluation of a clinical decision support system for detection of patients at risk after kidney transplantation

In: Frontiers in Public Health 10 (2022), Art.Nr.: 979448

ISSN: 2296-2565

DOI: 10.3389/fpubh.2022.979448

- , , , , , , , :

"Nothing works without the doctor:" Physicians' perception of clinical decision-making and artificial intelligence

In: Frontiers in Medicine 9 (2022)

ISSN: 2296-858X

DOI: 10.3389/fmed.2022.1016366

URL: https://www.frontiersin.org/articles/10.3389/fmed.2022.1016366/full

- , :

For the sake of multifacetedness. Why artificial intelligence patient preference prediction systems shouldn’t be for next of kin

In: Journal of Medical Ethics (2023)

ISSN: 0306-6800

DOI: 10.1136/jme-2022-108775

- , , , , , , , , , , :

When performance is not enough-A multidisciplinary view on clinical decision support

In: PLoS ONE 18 (2023), S. e0282619-

ISSN: 1932-6203

DOI: 10.1371/journal.pone.0282619

- , , , , , , :

Perspectives of patients and clinicians on big data and AI in health: a comparative empirical investigation

In: AI and Society (2024)

ISSN: 0951-5666

DOI: 10.1007/s00146-023-01825-8

- , , , :

Towards an Ethics for the Healthcare Metaverse

In: Journal of Metaverse 3 (2023), S. 181-189

ISSN: 2792-0232

DOI: 10.57019/jmv.1318774